AMD tuyên bố ra chip AI mạnh hơn 60% Nvidia H100

19 Tháng Mười Hai 2023AMD cho biết Instinct MI300X, chip mạnh nhất dùng để huấn luyện AI của hãng, có hiệu năng gấp 1,6 lần so với H100. Được giới thiệu lần đầu hồi tháng 6 và ra mắt chính thức ngày 6/12 tại sự kiện Advancing AI ở San Jose, California, Instinct MI300X nhắm đến các hệ thống huấn luyện AI. Trong sự kiện, AMD nêu đích danh mẫu chip của Nvidia là đối thủ chính.

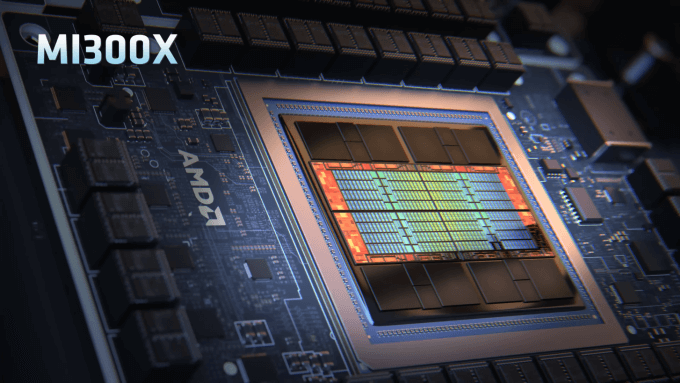

MI300X được xem là đỉnh cao về phương pháp thiết kế chiplet mới nhất mà AMD áp dụng cho bộ xử lý đồ họa (GPU), gồm kết hợp tám ngăn xếp bộ nhớ HBM3 12Hi với tám chiplet GPU 5nm CDNA 3 xếp chồng lên nhau dạng 3D, được đặt tên là XCD. Công nghệ lai này được AMD gọi là 3,5D, với sự kết hợp 3D và 2,5D. Kết quả là chip mới có công suất 750 W, sử dụng 304 đơn vị tính toán, dung lượng HBM3 192 GB và đạt băng thông 5,3 TB/s.

Bên trong MI300X được thiết kế để hoạt động theo nhóm với tổng cộng 8 phân vùng xử lý riêng. Thông qua kết nối Infinity Fabric, các vùng này sẽ giao tiếp với nhau với băng thông tốc độ 896 GB/s. Toàn bộ mang lại hiệu suất 10,4 Petaflop (triệu tỷ phép tính mỗi giây).

Theo công bố của AMD, MI300X có dung lượng bộ nhớ lớn hơn 2,4 lần và lợi thế về công suất tính toán là 1,3 lần so với nền tảng H100 - chip AI được sử dụng phổ biến trong các ứng dụng AI tạo sinh thời gian qua, bao gồm cả GPT-4 của OpenAI. Dung lượng bộ nhớ lớn sẽ giúp hiệu suất tính toán cao hơn do xử lý nhiều dữ liệu cùng lúc hơn.

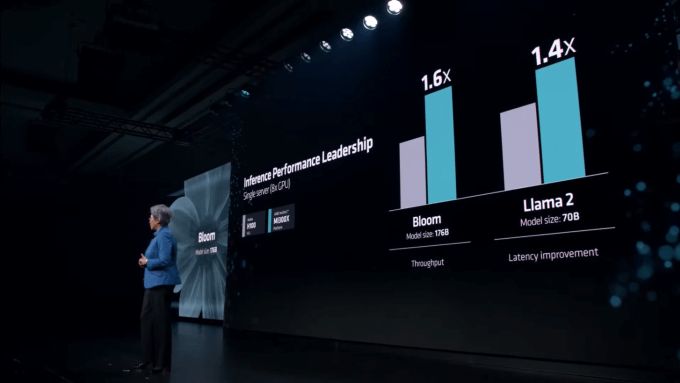

Khi thử nghiệm với các mô hình ngôn ngữ lớn, MI300X vượt trội đối thủ từ Nvidia. Với Llama 2 70B (70 tỷ tham số) và FlashAttention 2, chip AMD nhanh hơn 20% khi so sánh 1v1. Còn khi kết hợp 8v8 (8v8 Server), MI300X mạnh hơn 40% so với H100 khi chạy trên Llama 2 70B và tới 60% khi chạy trên Bloom 176B (176 tỷ tham số).

AMD nhấn mạnh MI300X ngang bằng với H100 về hiệu suất đào tạo, nhưng có giá cạnh tranh hơn khi so sánh cùng một khối lượng công việc. Dù vậy, công ty chưa công bố giá chính thức của sản phẩm.

Dù thông số mạnh, MI300X chưa phải là GPU mạnh nhất. Giữa tháng 11, Nvidia công bố H200 mới nhất của hãng với hiệu suất gần gấp đôi H100.

Bên cạnh Instinct MI300X, AMD cũng giới thiệu Instinct MI300A, bộ xử lý tăng tốc APU (Accelerated Processing Unit) cho trung tâm dữ liệu đầu tiên trên thế giới. Chip này cũng dùng kỹ thuật đóng gói 3,5D do TSMC đảm nhiệm tương tự MI300X, kết hợp hai tiến trình 5 nm và 6 nm với 13 chiplet được xếp chồng, tạo ra một chip có 24 lõi chứa 53 tỷ bóng bán dẫn. Đây cũng là chip lớn nhất AMD từng sản xuất. Công ty chưa công bố giá sản phẩm.

"Mọi sự quan tâm lớn đều đang đổ dồn vào chip AI", CEO AMD Lisa Su nói. "Những gì chip của chúng tôi mang lại sẽ trực tiếp chuyển thành trải nghiệm người dùng theo hướng tốt hơn. Khi bạn hỏi gì đó, câu trả lời sẽ xuất hiện nhanh hơn, đặc biệt khi các câu trả lời ngày càng phức tạp hơn".

Trong khi đó, Meta và Microsoft cho biết sẽ mua Instinct MI300X thay thế cho chip Nvidia. Đại diện Meta nói sẽ trang bị MI300X cho các hệ thống suy luận trí tuệ nhân tạo như xử lý nhãn dán AI, chỉnh sửa hình ảnh và vận hành trợ lý ảo. Còn Kevin Scott, CTO của Microsoft, cho biết sẽ dùng chip của AMD cho máy chủ đám mây Azure. OpenAI cũng sẽ dùng MI300X cho hệ thống xử lý phần mềm có tên Triton, mô hình được sử dụng trong nghiên cứu AI.

AMD dự đoán tổng doanh thu GPU cho trung tâm dữ liệu của hãng sẽ đạt khoảng 2 tỷ USD năm 2024. Công ty cũng ước tính tổng giá trị thị trường GPU AI có thể tăng lên 400 tỷ USD trong bốn năm tới. "Nvidia sẽ chiếm miếng bánh lớn trong đó, nhưng chúng tôi cũng sẽ được một phần xứng đáng", bà Su nói thêm.

Bài viết gốc tại đây.

>> Nvidia sắp ra mắt dòng GPU RTX 4070 Super

>> CPU Intel Core Ultra ra mắt, tập trung vào AI hỗ trợ Windows 12